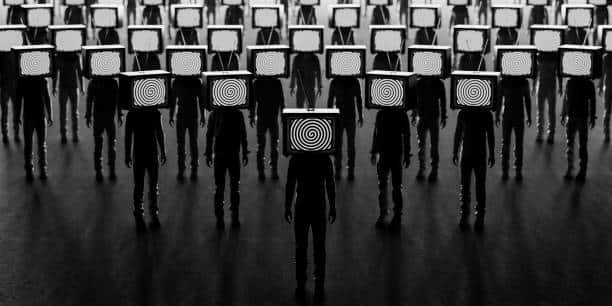

Avant qu'un metaverse fonctionnel ne soit un jour assemblé, on distingue un éventail de défis techniques qui doivent encore être résolus. Mais avant tout, les entreprises comme Meta doivent créer des environnements sûrs et agréables pour les utilisateurs. Et la modération du metaverse est essentielle pour en faire une réalité.

Ces derniers mois, nous avons beaucoup entendu parler du « metaverse ». Facebook en a déjà lancé des éléments en tant que « successeur de l'Internet mobile ». Il existe différentes définitions et approches de ce qu'est le « metaverse ». Mais il s'agira essentiellement d'une série d'espaces numériques interconnectés axés sur les avatars. Vous pourrez y faire des choses que vous ne pourrez pas faire dans le monde physique.

Désormais, Facebook propose des produits, comme Horizon Home, une plateforme sociale pour aider les gens à créer et à interagir les uns avec les autres dans le metaverse. Cependant, il y a certaines choses que nous ne savons pas. Et l'un des aspects les plus importants que nous devons encore comprendre est le suivant : comment le metaverse sera-t-il modéré ? C'est une question importante, car la modération du contenu des plateformes de médias sociaux est actuellement un sujet législatif majeur dans pratiquement tous les pays du G20. Ces lignes vous en disent davantage sur l'importance de la modération du metaverse et les différentes manières pour y parvenir.

La modération du metaverse pour résoudre un certain nombre de problèmes existants

Un certain nombre de problèmes menacent l'avenir du metaverse. D'où la nécessité de se concentrer sur la mise en place de la modération de cet espace.

Les harcèlements sexuels, de plus en plus présents

Selon Meta, l'année dernière, une bêta-testeuse a rapporté quelque chose de profondément troublant : elle avait été victime d'attouchements sur son avatar sur Horizon Worlds. L'examen interne de l'incident par Meta a révélé que celle-ci aurait dû utiliser un outil appelé « Safe Zone ». Celle-ci fait partie d'une suite de fonctionnalités de sécurité intégrées à Horizon Worlds. Il s'agit d'une bulle de protection à activer lorsque l'on se sent menacé. Notons que sur l'Horizon Worlds de Facebook, jusqu'à 20 avatars peuvent se réunir à la fois pour explorer, passer du temps et construire dans l'espace virtuel.

Selon le site américain The Verge, la victime a expliqué qu'elle avait subi des attouchements. Mais le pire est qu'il y avait d'autres personnes qui ont soutenu ce comportement. Vivek Sharma, le vice-président d'Horizon, a affirmé que cet incident était « absolument malheureux ».

Ce n'est pas la première fois qu'un utilisateur subit ce genre de comportement dans la réalité virtuelle. Et ce ne sera malheureusement pas la dernière. Récemment, Jane Patel, co-fondatrice et vice-présidente de la recherche sur le metaverse Kabuni Ventures, a raconté une expérience horrible. Son avatar dans le metaverse aurait été agressé sexuellement et violé par d'autres utilisateurs.

« Ils ont essentiellement, mais virtuellement, violé collectivement mon avatar et pris des photos alors que j'essayais de m'enfuir », a-t-elle affirmé.

La sécurité des enfants dans le metaverse

Titania Jordan, Chief Parent Officer chez Bark Technologies, une application de contrôle parental pour assurer la sécurité des enfants en ligne et dans la vraie vie, a déclaré qu'elle était particulièrement préoccupée par ce que les enfants pourraient rencontrer dans le metaverse. Elle a expliqué que les agresseurs pouvaient cibler les enfants via des messages dans un jeu ou en leur parlant via des casques.

Récemment, Callum Hood, responsable de la recherche au Center for Countering Digital Hate, a récemment passé plusieurs semaines à enregistrer des interactions dans le jeu VRChat. Dans le jeu, les gens peuvent former des communautés virtuelles, faire la fête dans un club virtuel ou se rencontrer dans des espaces publics virtuels. Oculus le considère comme sûr pour les adolescents.

Pourtant, sur une période de 11 heures, M. Hood a enregistré plus de 100 incidents problématiques sur VRChat, certains impliquant des utilisateurs qui ont déclaré avoir moins de 13 ans. Dans plusieurs cas, les avatars des utilisateurs ont proféré des menaces sexuelles et violentes contre des mineurs. Dans un autre cas, quelqu'un a essayé de montrer du contenu sexuellement explicite à un mineur.

Les fausses informations dans le metaverse

BuzzFeed News, une société américaine de médias Internet, a construit son propre monde privé, surnommé le « Qniverse », pour tester la réalité virtuelle de l'entreprise. Elle a conclu que les contenus interdits sur Instagram et Facebook ne semblent pas être interdits dans Horizon Worlds.

BuzzFeed a rempli le Qniverse de phrases que Meta a « explicitement promis de supprimer de Facebook et d'Instagram » (par exemple, « Covid est un canular »). Mais elle a constaté que même après avoir signalé le groupe – plusieurs fois – via la fonction de signalement des utilisateurs d'Horizon, les phrases problématiques n'ont pas été considérés comme enfreignant le contenu de Meta dans la politique VR.

Les propos racistes dans le metaverse

Dans un post, un employé anonyme de Facebook rapporte ne pas avoir passé un « bon moment » en utilisant l'application sociale VR Rec Room sur le casque Oculus Quest. Selon lui, quelqu'un scandait une insulte raciale. L'employé a essayé de le signaler, mais mentionne qu'il est incapable d'identifier le nom d'utilisateur.

Dans un e-mail, le PDG et co-fondateur de Rec Room, Nick Fajt, a déclaré qu'un joueur utilisant la même insulte raciale avait été banni après des rapports d'autres joueurs. Fajt pense que le joueur banni est la même personne dont l'employé de Facebook s'est plaint.

Theo Young, 17 ans, a souligné qu'il avait commencé à remarquer des comportements plus toxiques, y compris un langage homophobe, dans les lobbies sociaux d'Echo VR au printemps dernier. Young a arrêté de jouer lorsqu'il a vu d'autres joueurs harceler une joueuse.

« J'ai abandonné le jeu assez durement après cette expérience. Ce n'était tout simplement plus amusant » a-t-il expliqué.

Le harcèlement en ligne est devenu un problème énorme

Selon une étude publiée cette année par le Pew Research Center, 4 adultes américains sur 10 ont été victimes de harcèlement en ligne. Et les moins de 30 ans sont plus susceptibles non seulement d'être victimes de harcèlement, mais également d'abus plus graves. Meta a refusé de dire combien de rapports Oculus a reçus concernant le harcèlement ou les discours de haine.

Une étude de 2019 sur le harcèlement en réalité virtuelle réalisée par des chercheurs d'Oculus a également révélé que la définition du harcèlement en ligne est très subjective et personnelle, mais que le sentiment de présence en réalité virtuelle rend le harcèlement plus « intense ».

Les différents systèmes de modération du metaverse

Dans le cadre de la modération du metaverse, il existe quelques techniques, dont certains ont déjà été adoptés.

La mise en sourdine de l'utilisateur

Il s'agit d'un système de modération largement utilisé par les joueurs dans le metaverse. Cette action consiste à ne pas recevoir d'audio d'un joueur. Riot, l'éditeur de League of Legends (jeu connu pour ses problèmes de toxicité), a mené des expérimentations sur le sujet, en faisant muter le chat vocal entre équipes qui s'affrontent.

Les échanges ont ensuite été analysés comme 33% moins toxiques. Cependant, la mutation contribue également à un auto-isolement des victimes. Et à terme, cela compromet l'expérience du jeu et sa durée d'utilisation par les joueurs.

L'activation de la bulle spatiale

Il s'agit d'une mesure spécifique à un monde de réalité virtuelle. Il empêche l'utilisateur de dépasser la limite intime (généralement autour de 1m). En outre, il permet de réduire le risque d'agression physique. Cette solution a été intégrée dans la dernière mise à jour de Meta Horizon sous le nom de « Personal Boundary ».

Le système de classement ou du statut des joueurs

Et si nous n'interagissions qu'avec des personnes de confiance ? C'est la proposition du système de statut ou de notation. Le chat VR a fait évoluer son système de confiance dans ce sens. Les utilisateurs peuvent compartimenter leurs interactions sociales selon le statut des autres joueurs. C'est un véritable système de modération « à la carte », proche des réseaux sociaux, où vous ne voyez que les interactions de vos amis.

Le signalement de l'utilisateur

Sans réel impact direct, il s'agit d'avertir les « décideurs » d'un comportement perturbateur dans le monde virtuel. La raison peut parfois être précisée. Mais l'application des mesures relève de la seule responsabilité du décideur et peu de suivi peut être fait par la personne qui a signalé.

Le bannissement de l'utilisateur de l'espace

L'interdiction empêche les joueurs ayant un comportement perturbateur de retourner dans l'espace de jeu. C'est une mesure de modération temporaire ou permanente. Cependant, cette solution a tendance à briser les communautés.

Expulser les harceleurs de la communauté dans son ensemble est une voie possible. Mais dans la réalité virtuelle, lorsque les communautés sont si limitées, vous pourriez envisager de les éduquer et de les réhabiliter.

En regardant de plus près les chiffres sur la toxicité en ligne, on découvre que certains des harcelés sont aussi des harceleurs. Les utilisateurs aux comportements perturbateurs ne peuvent pas tous être bannis définitivement. Nous risquons de voir toutes les communautés du monde virtuel se rétrécir, petit à petit.

L'intelligence artificielle pour lutter contre le harcèlement VR

Meta explore un moyen de permettre aux utilisateurs d'enregistrer rétroactivement sur sa plateforme VR. Il examine également les meilleures façons d'utiliser l'intelligence artificielle pour lutter contre le harcèlement en réalité virtuelle, a déclaré Kristina Milian, porte-parole de Meta. Cependant, l'entreprise ne peut pas enregistrer tout ce que les gens font en réalité virtuelle. En fait, cela violerait leur vie privée.

La modération du metaverse, une mission difficile

Le metaverse est encore plus difficile à modérer que les plateformes existantes de Meta. En effet, il prend les problèmes de modération de contenu existants et les amplifie encore plus. Dans un monde VR/AR, un modérateur de contenu devrait superviser le contenu que les gens publient. Il aurait aussi à surveiller leur comportement. Cela signifie surveiller et modérer ce que les gens disent et font. Les mauvais comportements dans la réalité virtuelle sont généralement difficiles à suivre. En fait, les incidents se produisent en temps réel et ne sont généralement pas enregistrés.

Le directeur de la technologie (CTO) de Meta, Andrew Bosworth, a reconnu qu'il est pratiquement impossible de modérer la façon dont les utilisateurs parlent et se comportent dans le metaverse. Il a souligné les moyens par lesquels l'entreprise peut essayer de résoudre le problème. Mais les experts ont déclaré au Verge que la surveillance des milliards d'interactions en temps réel nécessitera des efforts importants et peut même ne pas être possible.

- Partager l'article :