Habituellement, pour identifier des objets dans un environnement à l'aide de lunettes AR, il faudrait intégrer des capteurs de profondeur pour estimer la distance des objets par rapport à l'utilisateur. Mais lors d'une démonstration, Meta a présenté une avancée où seule l'intelligence artificielle (IA) est utilisée pour exécuter cette tâche. Et cela, sans nécessiter de dispositifs matériels supplémentaires. Ici les détails.

Meta AI, un laboratoire d'IA appartenant à Meta Platforms Inc, a publié une vidéo intrigante. Elle y présente une belle avancée dans le domaine de la réalité augmentée (AR) avec ses lunettes Project Aria. Ces dernières sont conçues pour capturer un nuage de points, une représentation numérique tridimensionnelle de l'environnement. Le modèle SceneScript, basé sur Llama AI, est capable d'analyser ce nuage de points capturé par les lunettes Project Aria. Il interprète ces données pour reconnaître des éléments du monde réel, comme des murs, des fenêtres et des meubles.

Cette démonstration montre donc comment les lunettes Project Aria peuvent collecter des informations sur l'environnement physique et comment le modèle IA de Meta AI peut analyser ces données pour comprendre les objets du monde réel.

Toutes ces données se transforme en un fichier texte bien structuré en anglais, avec des dimensions d'objets. Assez détaillé pour dessiner des contours ou créer des modèles 3D.

Lunettes AR Meta, IA et SceneScript révèlent un avenir augmenté

L'utilisation du logiciel SceneScript sur un Meta Quest 3 a permis aux chercheurs d'afficher les données du nuage de points superposées avec les éléments de scène étiquetés. Cette avancée ouvre la voie à de nouvelles possibilités dans les applications AR. Par ailleurs, elle souligne le potentiel de la technologie Meta AI dans ce domaine.

Ce qui est vraiment impressionnant ? SceneScript produire aussi des géométries plus complexes. De ce fait, les détails des tables, des chaises de bureau et des canapés sont plus fins.

Bien sûr, il y a quelques limites à cette magie. Le processeur Snapdragon 835 dans ces prototypes n'est pas tout à fait à la hauteur du défi de traitement. Et sans capteur de profondeur, tout le travail est basé sur la vision seulement.

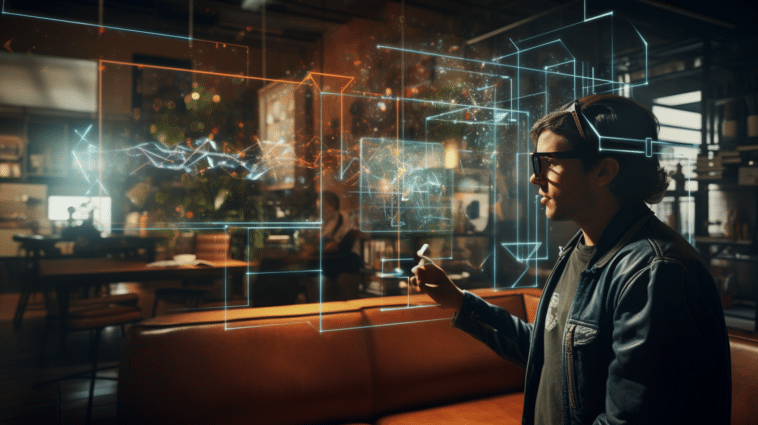

Alors que SceneScript reste une exclusivité pour les chercheurs, on ne peut s'empêcher de rêver aux possibilités futures. Cela nous donne un avant-goût appétissant de ce qui nous attend dans le futur de la réalité augmentée. Imaginez des expériences de réalité augmentée où votre environnement réel se mélange avec le virtuel, comme si vous étiez dans un film de science-fiction.

Attendez-vous à ce que les lunettes AR de Meta, superchargées par l'IA, bousculent complètement notre manière de voir les choses.

- Partager l'article :